目录

一、什么是Robots.txt

二、为什么Robots.txt对谷歌SEO很重要?

三、正确使用Robots.txt的流程

01

什么是Robots.txt

Robots.txt 是一个用于管理搜索引擎爬虫的文本文件。

使用Robots来指示搜索引擎爬虫哪些页面或部分内容可以被,哪些不可以爬取。Robots规则文件通常位于网站的根目录下,名称为 robots.txt。

02

为什么Robots.txt对谷歌SEO很重要?

1.控制搜索引擎爬虫访问

网站管理员控制哪些页面或部分内容可以被搜索引擎爬虫访问和索引。这有助于避免不必要的页面被索引,例如:

通过限制这些内容,可以提高重要页面在搜索结果中的表现。

2.提高抓取效率

搜索引擎爬虫有一个抓取预算,即它们在每个网站上花费的时间和资源是有限的。通过使用 robots.txt 文件阻止爬虫访问无关或低价值的页面,可以将爬虫的抓取预算集中在更重要的页面上,从而提高这些页面的索引速度和频率。

3.屏蔽非公开页面

某些页面或文件可能包含敏感信息(例如感谢页面),不希望被公开搜索或索引。通过robots.txt,可以阻止搜索引擎爬虫访问这些内容,从而防止它们出现在搜索结果中。

4.避免搜索引擎惩罚

一些搜索引擎(包括谷歌)可能会对重复内容、低质量页面或违反搜索引擎指南的内容进行惩罚。通过 robots.txt 文件,可以有效地管理和控制这些内容,避免不必要的搜索引擎惩罚,从而维护或提高网站的搜索排名。

03

正确使用Robots.txt的流程

1.Robots规则

格式规范:

指令与规则:

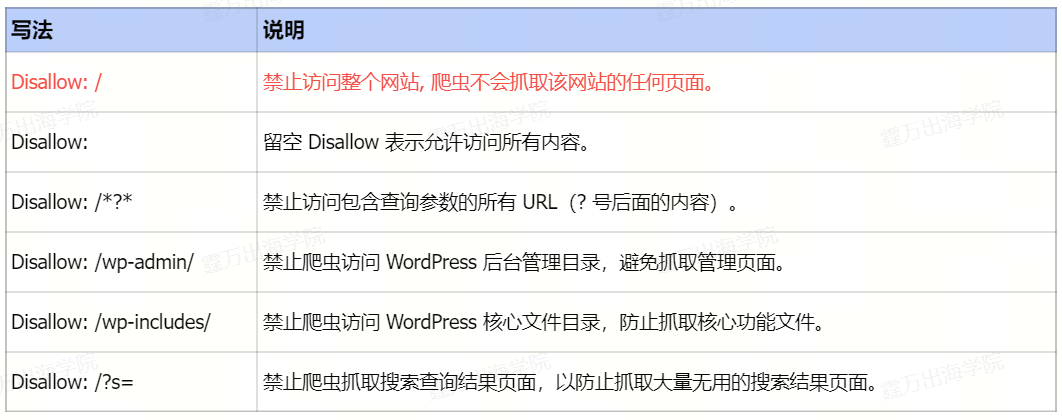

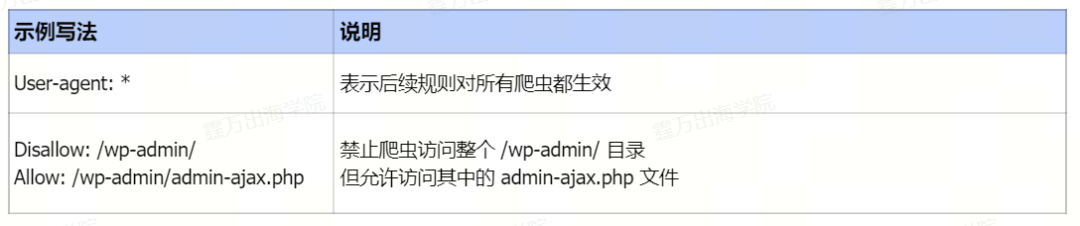

robots.txt文件由一系列的指令组成,每个指令占一行。常见的指令包括User-agent、Disallow、Allow和。

①User-agent

②Disallow

*特别强调 Disallow: / 不要轻易去配置,防止忘记取消,会导致全站不被收录。

③Allow

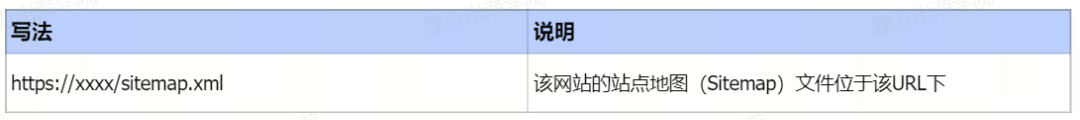

④Sitemap

注意事项:

2.手动创建Robots文件

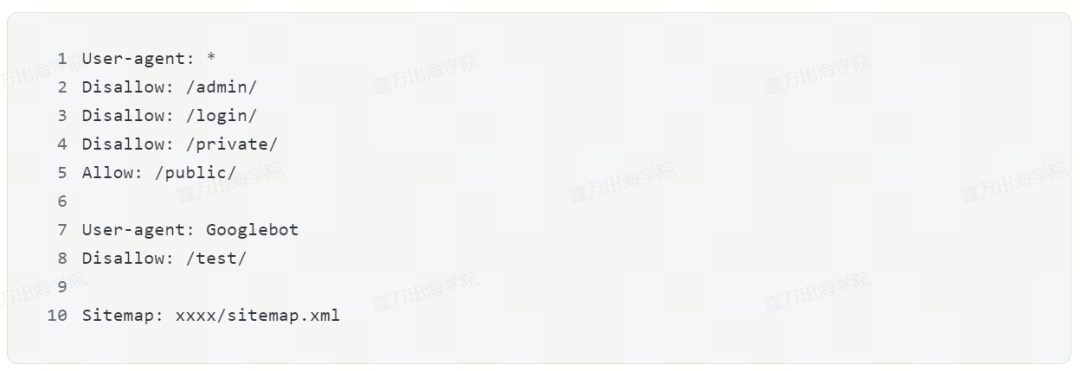

使用文本编辑器创建一个新的文件,并命名为 Robots.txt。在robots.txt 文件中添加你希望搜索引擎遵循的规则,编写示例:

该文件表示:

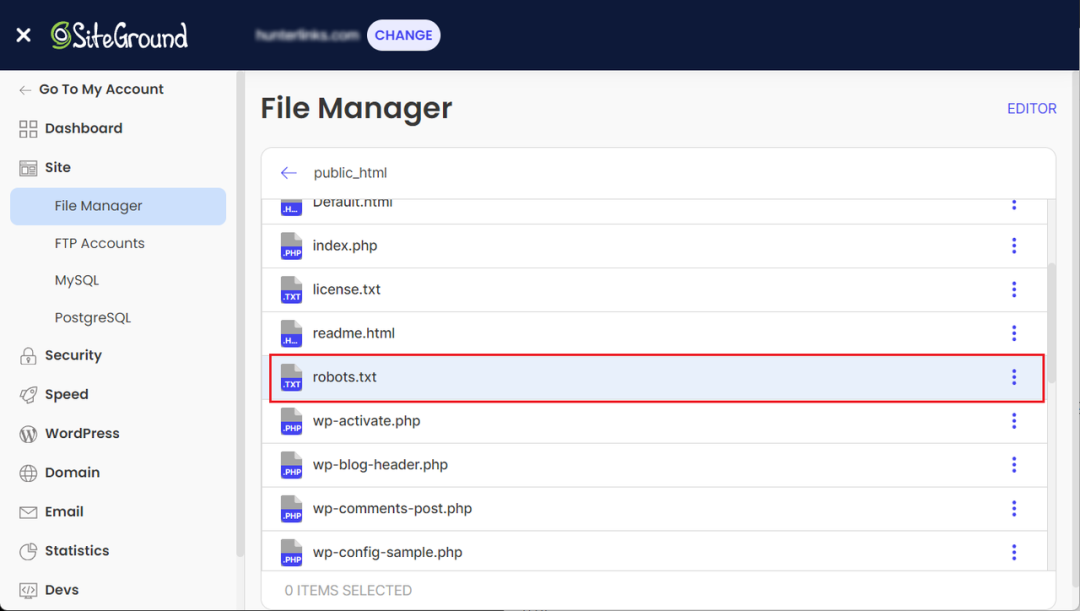

3.Robots文件上传到网站

将 robots.txt 文件上传到你的网站的根目录,下图以siteground虚拟主机为例:

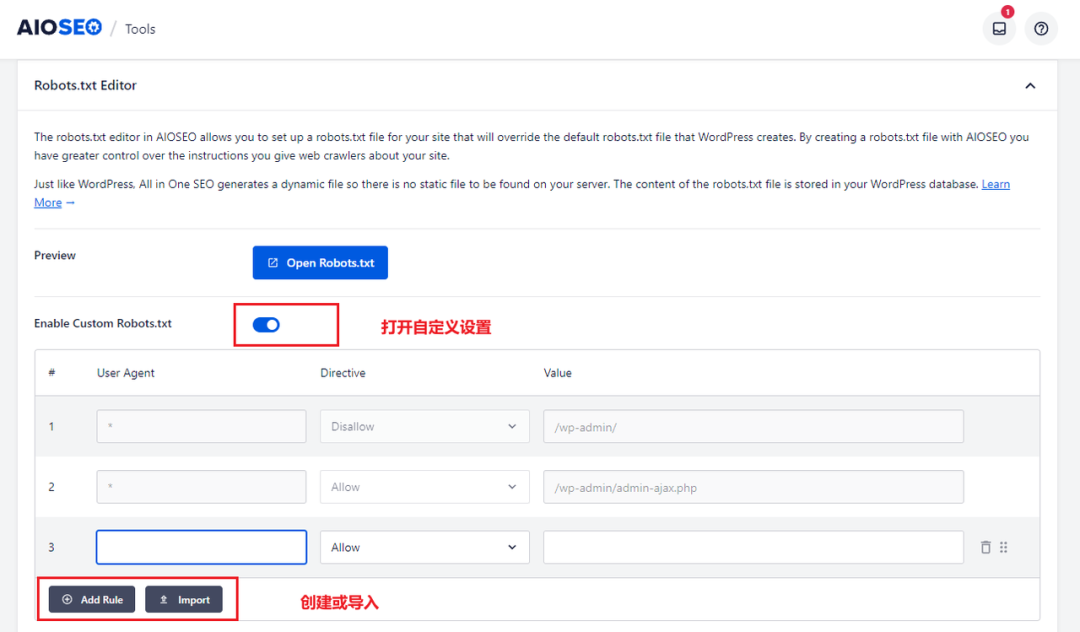

4.自动化创建Robots文件

第三方建站系统:WordPress 可以搭配插件进行自动化设定

推荐插件:AIOSEO、Rank Math SEO、Yoast SEO、SEOPress

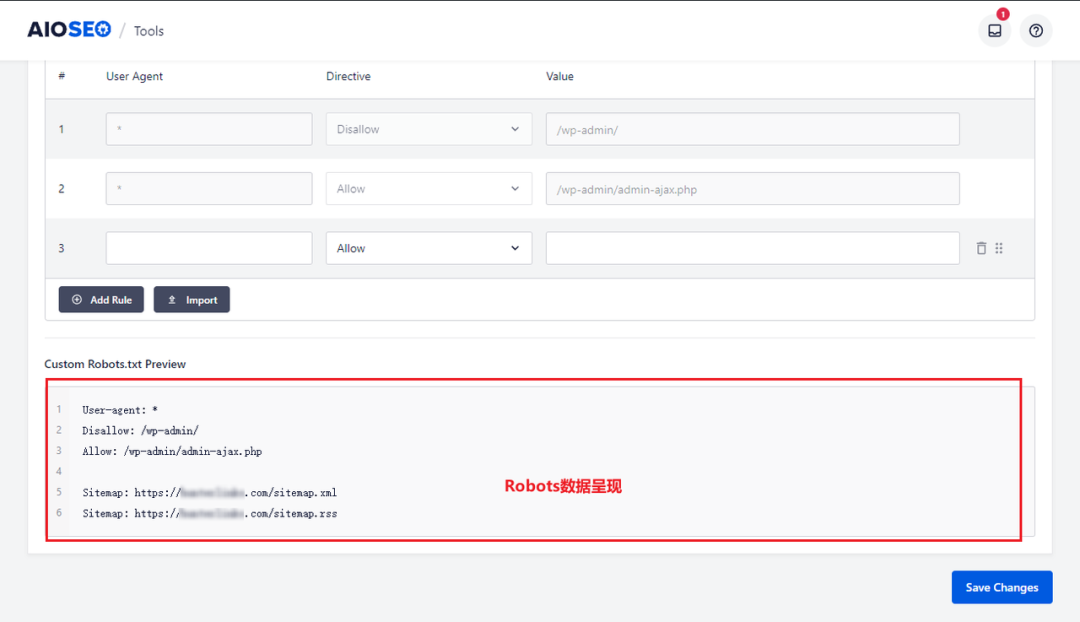

我这里使用AIOSEO插件生成Robots,具体示例如下:

在AIOSEO插件的Tools菜单栏目下,进行Robots.txt Editor ,先打开Enable Custom Robots.txt 开关,然后 Add Rule或者Import创建或导入Robots规则,最后保存即可看到实际效果。

创建后的数据呈现:

创建完成之后,在Custom Robots.txt Preview这里就能看到实际效果,也可以访问: 进行查看。

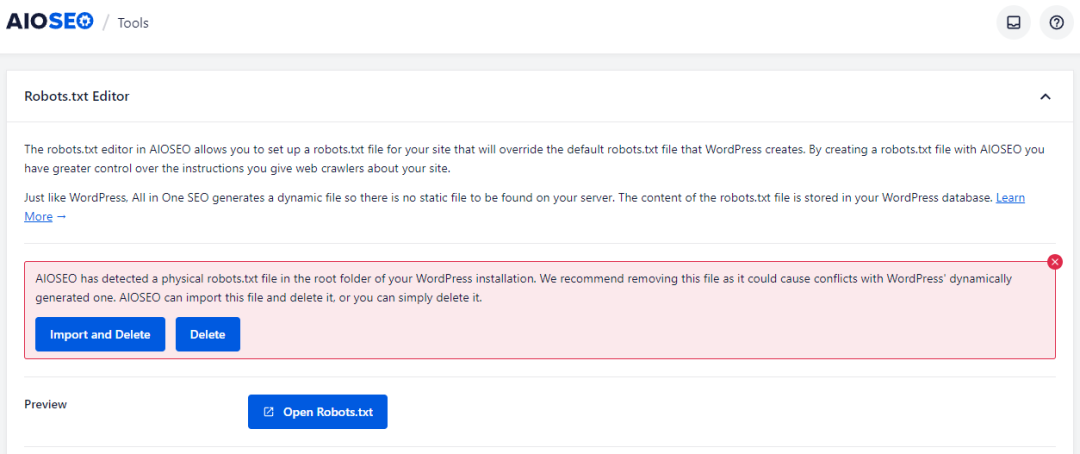

注意事项:

当我们网站根目录,已经存在robots.txt静态文件时,使用AIOSEO插件生成,会出现上面错误提示,因为这些插件是使用的虚拟的Robots文件(即不会在网站目录创建真实的静态文件),如果同时保留两者,出现Robots冲突。

5.测试Robots文件

测试Robots.txt文件可以通过以下几种方式进行:

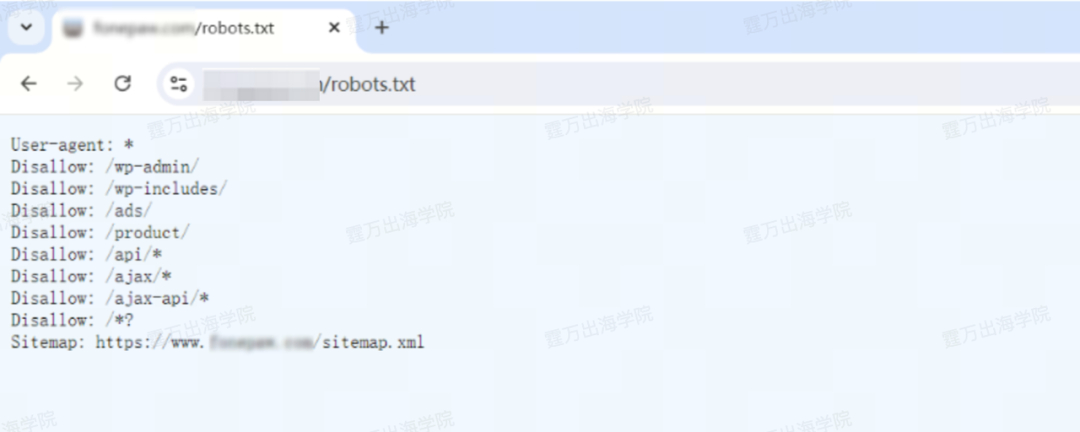

①浏览器访问测试

在浏览器中访问 ,确保文件能够正确显示。

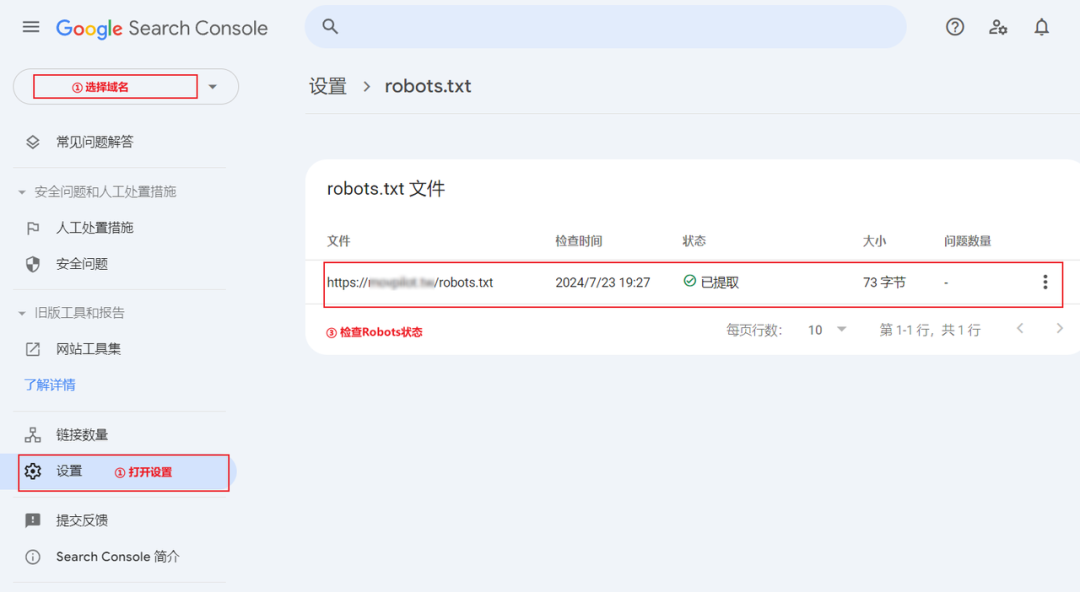

②Google Search Console工具测试

③第三方在线工具测试

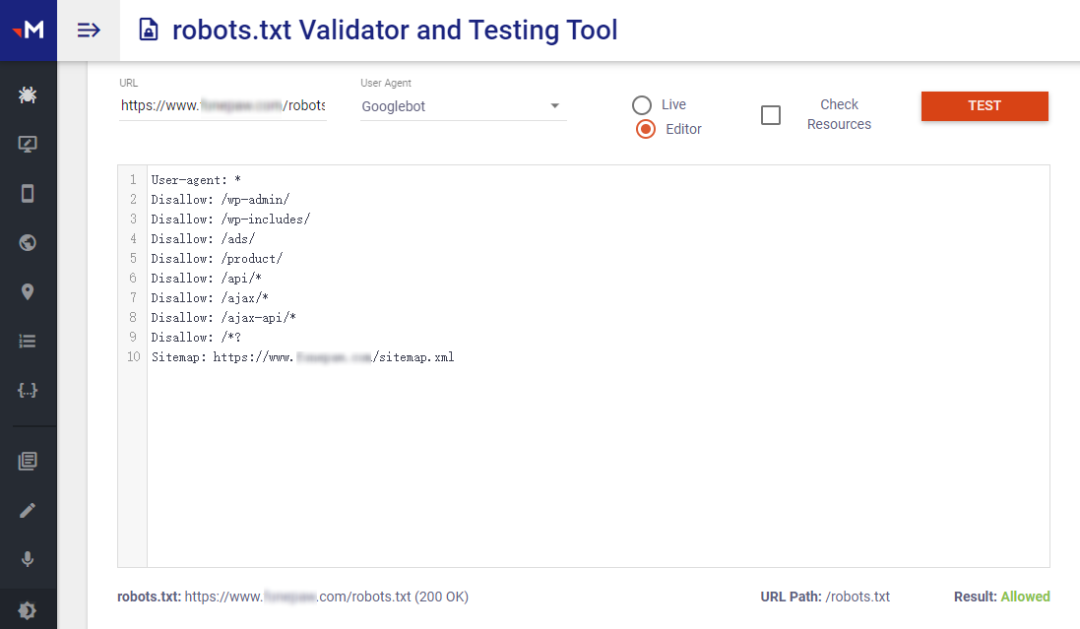

可以使用一些在线工具来测试你的 robots.txt 文件,例如:Technicalseo Robots.txt Tester(访问网址:)

这些工具可以帮助我们检查 Robots.txt 文件是否正确,并确保搜索引擎爬虫能够正确解析和遵循其中的规则。

以上就是今天文章的全部内容了,希望能对你了解外链有帮助。另外,为了帮助大家更全面地掌握技术SEO的相关知识,我们也准备了一份详尽的谷歌SEO运营指南。点击文末的【阅读原文】按钮即可免费领取高清版~

以上内容由霆万科技/霆万出海学院原创/转载,请勿私自转载,以免侵权!如需转载,请扫码添加客服,获得授权并注明来源。

广州霆万科技有限公司是一家专注于软件出海的服务创新企业,至今已积累12年的软件品牌独立站运营经验,总部在广州,分公司在深圳。我们致力于帮助中国软件品牌出海,解决从市场调研、商业化验证、团队组建,到策略规划、营销推广和运营实施等难题。